[AI] ViT(Vision Transformer)_ 1/5

AI

When Vision Transformers Outperform ResNets without Pretraining or Strong Data Augmentations [4]

이 논문은 ViT가 어떻게 Pretraining(사전학습)이나 strong data augmentations(강력한 데이터 증강) 없이 Resnet보다 뛰어난 성능을 보일 수 있는지 실험한 논문이다. ViTs나 MLP-Mixers가 훈련할 떄 데이터 효율성을 개선하고, 추론 시에는 일반화 성능을 향상시키기 위해 손으로 설계한 특징이나 귀납적 편향을 일반적인 신명망 구조로 대체하는 것에 집중하고 있다. 기존 모델들은 Pretraining이나 strong data augmentation을 반복적으로 사용해 모델을 강화하고 있으나, 초기화나 학습속데에 아직 한계가 있다.

그래서 이 논문은 ViTs와 MLP-Mixers의 Loss geometry를 시각화하고 Hessian 분석을 통해 해결하고자 한다. 수렴한 모델들은 극도로 날카로운 local minima를 확인하고, shapness-aware optimizer를 사용해 smoothness를 촉진하여 정확도와 견고성을 향상시켰다.

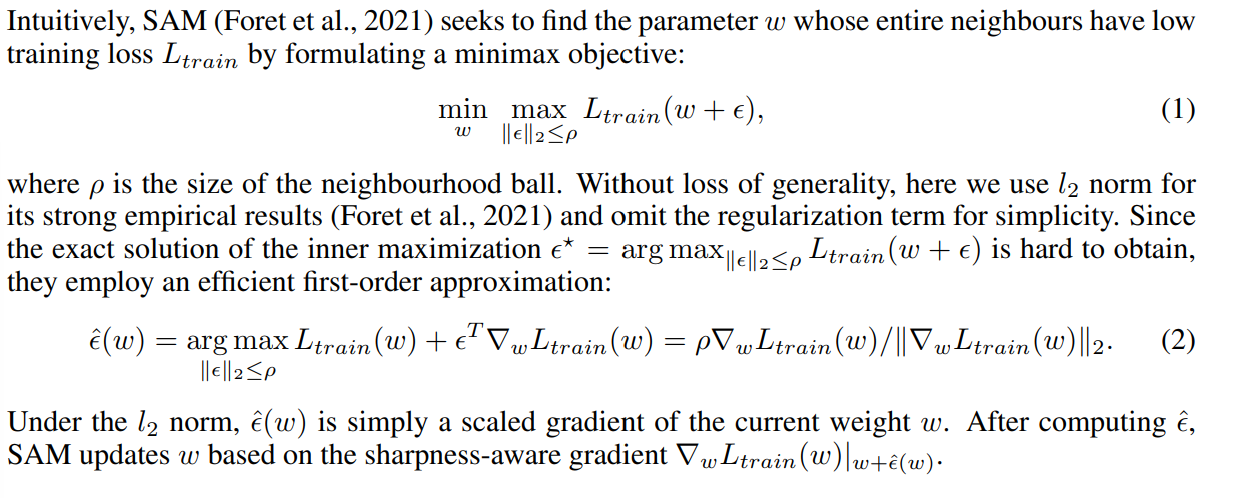

SAM(sharpness-aware minimizer)

SAM은 직관적으로 parameter weight 를 찾는다. 의 모든 neighbours는 낮은 training loass 을 갖는다. 는 neighbourhood ball의 사이즈이다. 일반성의 손실 없이, norm을 사용하여 강력한 emprical results를 얻고 단순성의 정규화(regularization)을 제거한다. Inner minimiztion의 정확한 해결책인 을 얻기 어렵지만, 효율적으로 first-order approximation을 적용하도록 한다. norm을 사용하여, 간단히 의 scaled grainet를 얻고, SAM은 를 sharness-aware gradient를 통해서 업데이트 할 수 있다.

Reference

[1] Alexey Dosovitskiy, et al, An Image is Worth 16x16 Words: Transformers for Image Recognition at Scale, ICLR, 2021.

[2] Ilya Tolstikhin, et al, MLP-Mixer: An all-MLP Architecture for Vision, CVPR, 2021.

[3] Andreas Steiner, et al, How to train your ViT? Data, Augmentation, and Regularization in Vision Transformers, CVPR, 2022.

[4] Xiangning Chen, et al, When Vision Transformers Outperform ResNets without Pretraining or Strong Data Augmentations, CVPR, 2022.

[5] Xiaohua Zhai, et al, LiT: Zero-Shot Transfer with Locked-image text Tuning, CVPR, 2022.

[6] Juntang Zhuang, Surrogate Gap Minimization Improves Sharpness-Aware Training, ICLR, 2022.