AI

Surrogate Gap Minimization Improves Sharpness-Aware Training [6]

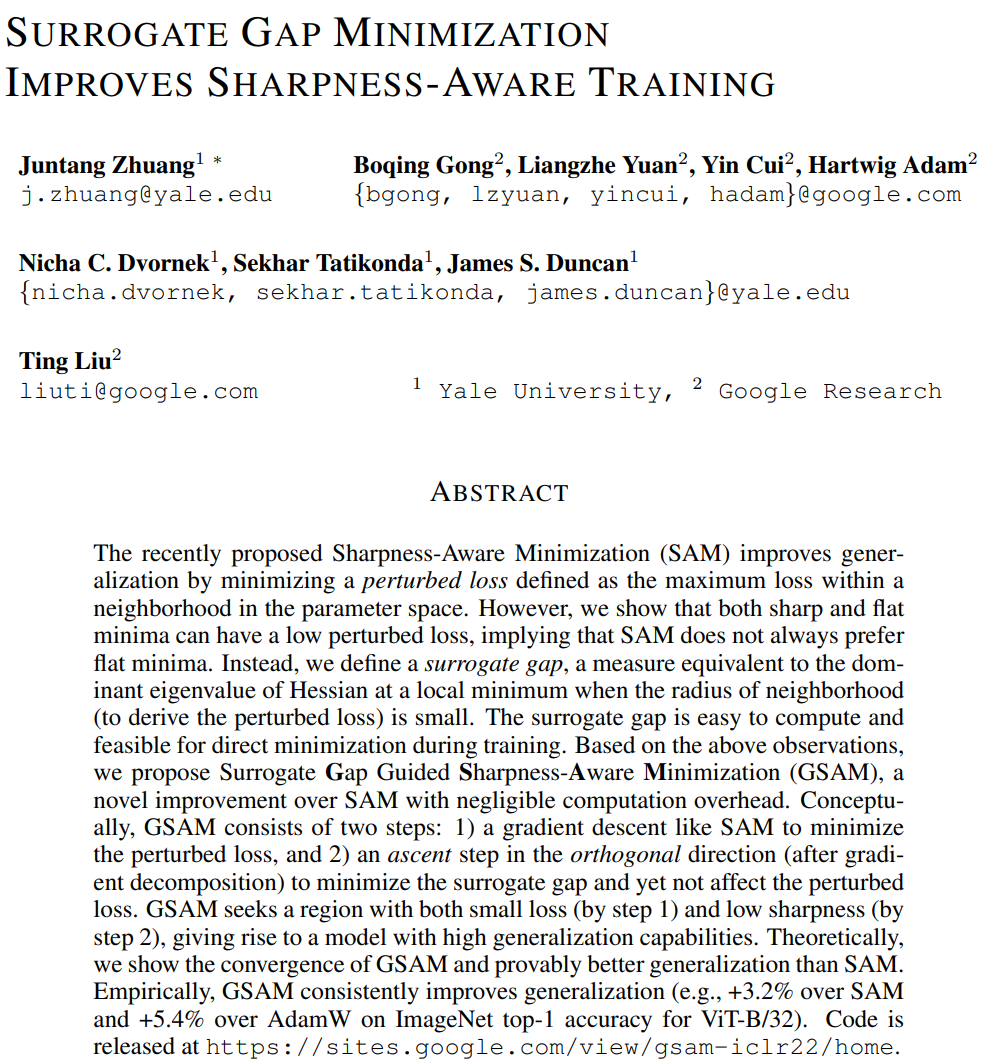

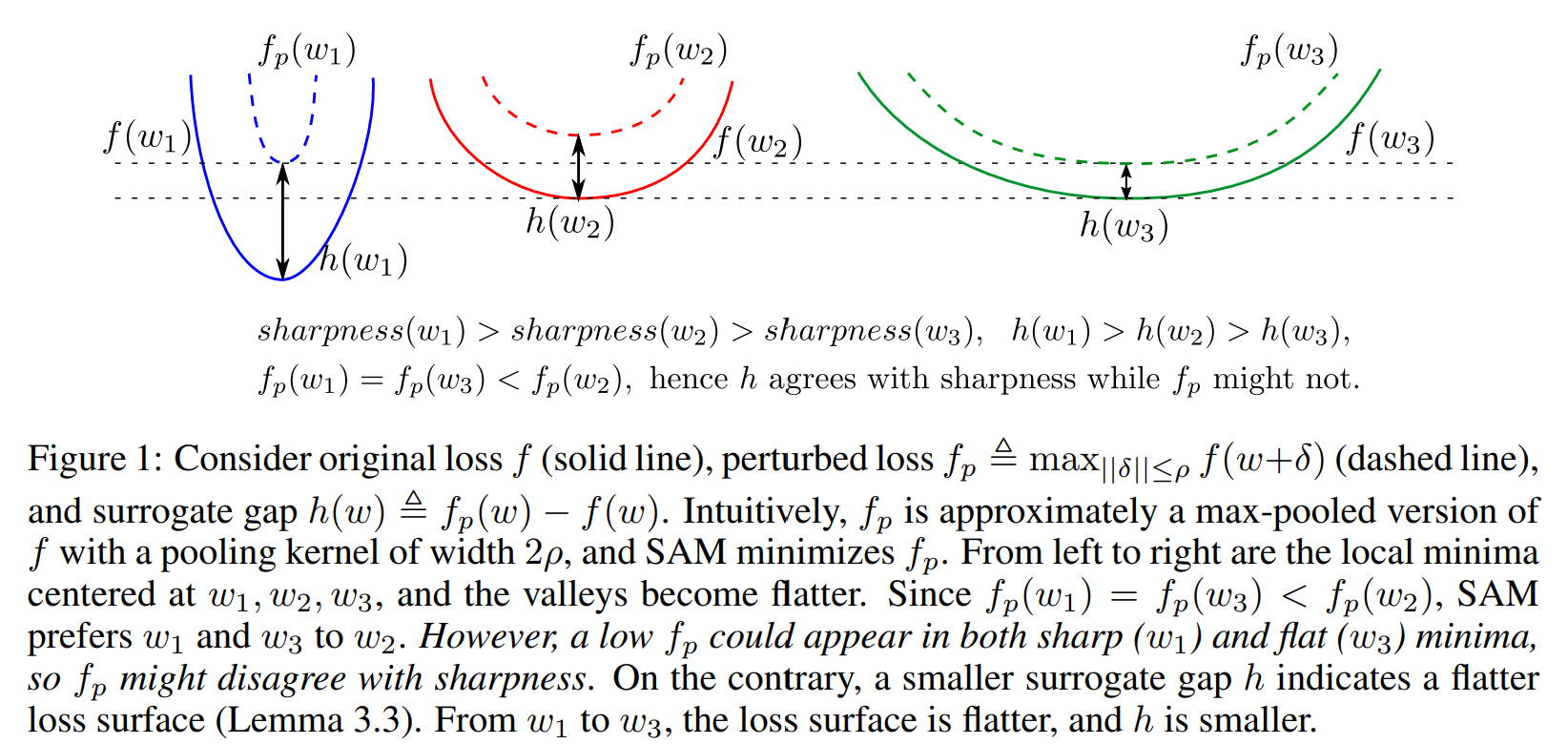

최근 제안된 Sharpness-Aware Minimization(SAM)은 파라미터 공간에 있는 최대 손실을 perturbed loss 를 최소화하도록 일반화하도록 개선되었다. 그러나, sharp & flat minima는 낮은 perturbed loss를 보이며, SAM이 항상 flat minima를 보이는 것이 아님을 암시한다. 이 논문에서는 surrogagte gap 통해서 neighborhood의 radius가 작을 때 local minima에서 Hessian의 우세한 eigenvalue와 상응하는 방법을 정의했다. Surrogate gap은 학습하는 동안 직접적인 minimization을 위한 계산과 이용이 쉽다. 여기서는 Surrogae Gap Guided Sharpness-Aware Minization(GSAM)을 제안하였다. SAM의 overhead를 무시하도록 개선된 방법이다.

Reference

[1] Alexey Dosovitskiy, et al, An Image is Worth 16x16 Words: Transformers for Image Recognition at Scale, ICLR, 2021.

[2] Ilya Tolstikhin, et al, MLP-Mixer: An all-MLP Architecture for Vision, CVPR, 2021.

[3] Andreas Steiner, et al, How to train your ViT? Data, Augmentation, and Regularization in Vision Transformers, CVPR, 2022.

[4] Xiangning Chen, et al, When Vision Transformers Outperform ResNets without Pretraining or Strong Data Augmentations, CVPR, 2022.

[5] Xiaohua Zhai, et al, LiT: Zero-Shot Transfer with Locked-image text Tuning, CVPR, 2022.

[6] Juntang Zhuang, Surrogate Gap Minimization Improves Sharpness-Aware Training, ICLR, 2022.